Di dunia Barat, kasus penipuan paling awal yang diketahui tercatat pada 300 SM.

Sejak itu, scam artists, fraudsters dan aktor jahat lainnya memanfaatkan manusia.

Seiring berkembangnya teknologi kita, begitu juga skema jahat.

Sekarang, artificial intelligence (AI) telah bergabung dengan daftar panjang dari human tricksters dan con artists.

Penggunaan teknologi AI dan machine learning (ML) meningkatkan phishing dan penipuan dunia maya lainnya ke tingkat yang benar-benar baru, sehingga semakin mempersulit perusahaan untuk mendeteksi dan mengidentifikasi ancaman.

Dibandingkan dengan penjahat siber manusia, algoritme belajar memanfaatkan korbannya dalam skala yang lebih besar dan lebih efisien.

Tokoh Phishing Terbaik

Dengan menggunakan model bahasa pembelajaran yang mendalam seperti peretas GPT-3, dapat dengan mudah meluncurkan kampanye spear phishing massal, sebuah serangan yang melibatkan pengiriman pesan yang dipersonalisasi.

Pada konferensi keamanan Black Hat dan Defcon 2021 di Las Vegas, tim dari Badan Teknologi Pemerintah Singapura mempresentasikan eksperimen di mana rekan-rekan mereka menerima dua set email phishing yang pertama ditulis manusia, sementara algoritma menulis yang kedua.

Al memenangkan kontes dengan mengumpulkan lebih banyak klik ke tautan di email dibandingkan dengan pesan yang ditulis manusia.

Dengan jumlah platform AI yang berlipat ganda, peretas dapat memanfaatkan AI sebagai layanan berbiaya rendah untuk menargetkan kumpulan besar korban, serta mempersonalisasi email mereka hingga detail yang sangat kecil sehingga tampak senyata mungkin.

Sejarah AI Panjang Penipuan Kecerdasan Buatan

Sementara serangan AI-as-a-service adalah fenomena yang relatif baru dan masih jarang, mesin telah diketahui menipu manusia selama beberapa dekade.

Joseph Weizenbaum menulis di tahun 1960-an program pertama, Eliza, yang mampu berkomunikasi dalam bahasa alami dan berpura-pura menjadi psikoterapis.

Weizenbaum terkejut bahwa staf lab MIT-nya memandang apa yang sekarang dikenal sebagai “chatbot” sebagai dokter sungguhan.

Mereka berbagi informasi pribadi mereka dengan Eliza, terkejut mengetahui bahwa Weizenbaum dapat memeriksa log percakapan antara mereka dan “dokter.”

Weizenbaum juga terkejut bahwa program sederhana seperti itu dapat dengan mudah menipu pengguna untuk mengungkapkan data pribadi mereka.

Dalam beberapa dekade sejak itu, manusia belum belajar untuk tidak mempercayai komputer dan menjadi semakin rentan.

Baru-baru ini, seorang engineer di Google mengumumkan secara mengejutkan manajemen dan rekan-rekannya bahwa chatbot AI perusahaan LaMDA (Language Model for Dialogue Applications) telah hidup kembali.

Blake Lemoine mengatakan dia percaya bahwa LaMDA adalah makhluk seperti manusia.

LaMDA mampu meniru percakapan manusia dengan sangat baik sehingga bahkan seorang insinyur berpengalaman pun tertipu olehnya.

Model percakapan ini mendasarkan tanggapan mereka pada informasi yang mereka pelajari dari media sosial, interaksi sebelumnya, dan psikologi manusia, dengan ini tidak menunjukkan bahwa mereka memahami arti kata-kata atau memiliki perasaan.

Tetapi tingkat mimikri perilaku dan sosial manusia ini memungkinkan peretas untuk memanfaatkan alat yang mirip dengan LaMDA untuk menambang data media sosial dan mengirim atau memposting pesan spear phishing.

Munculnya Rekayasa Sosial Deepfake

AI tidak hanya mampu melakukan mimikri percakapan.

Baik transfer gaya suara, juga dikenal sebagai konversi suara (kloning digital dari suara target) dan deepfake (gambar atau video palsu dari seseorang atau suatu peristiwa) adalah ancaman dunia maya yang sangat nyata.

Pada tahun 2019, dalam apa yang diyakini banyak ahli sebagai kasus pertama yang didokumentasikan dari serangan semacam itu, penipu menggunakan konversi suara untuk menyamar sebagai CEO dan meminta transfer dana mendesak (ke akun mereka).

Setahun kemudian, pada tahun 2020, sekelompok penipu lain menggunakan teknologi untuk meniru suara klien guna meyakinkan manajer bank untuk mentransfer $35 juta demi menutupi “akuisisi.”

Serangan rekayasa sosial bertarget bertenaga AI seperti itu telah diperkirakan, namun sebagian besar perusahaan tidak siap.

Dalam survei Attestiv, 82% pemimpin bisnis mengakui bahwa deepfake menimbulkan risiko, tetapi kurang dari 30% telah mengambil langkah apa pun untuk meminimalkannya.

Mengelabui AI Penipu

Dengan begitu banyak serangan dunia maya yang berbeda dan harus diwaspadai selama 24×7, tidak mengherankan jika perusahaan kewalahan.

Sampai saat ini, serangan yang dirancang AI telah terbukti efektif, mereka ditargetkan dengan baik.

Teknologi AI terus memperluas ancaman keamanan siber yang ada dan berpotensi menjadi terlalu “pintar” untuk dipahami manusia.

Dan seperti yang ditunjukkan sejarah, manusia dapat dengan mudah ditipu, tetapi alat AI juga dapat membantu kita.

Deepfake dapat dilawan dengan algoritme yang disesuaikan untuk menemukannya.

Alat analitik canggih dapat membantu menandai aktivitas penipuan atau mencurigakan.

Model machine learning dapat berhasil menargetkan upaya phishing dan scam paling canggih.

Bagaimana Bitdefender Membantu Anda dengan Machine Learning

Machine learning di industri keamanan juga terbukti sangat efektif dalam menemukan malware baru atau tidak dikenal, berdasarkan fitur yang dimiliki malware baru dengan ancaman yang diketahui sebelumnya.

Namun, kita perlu melatih algoritme machine learning dengan kumpulan data yang terdiri dari sampel malware yang diketahui.

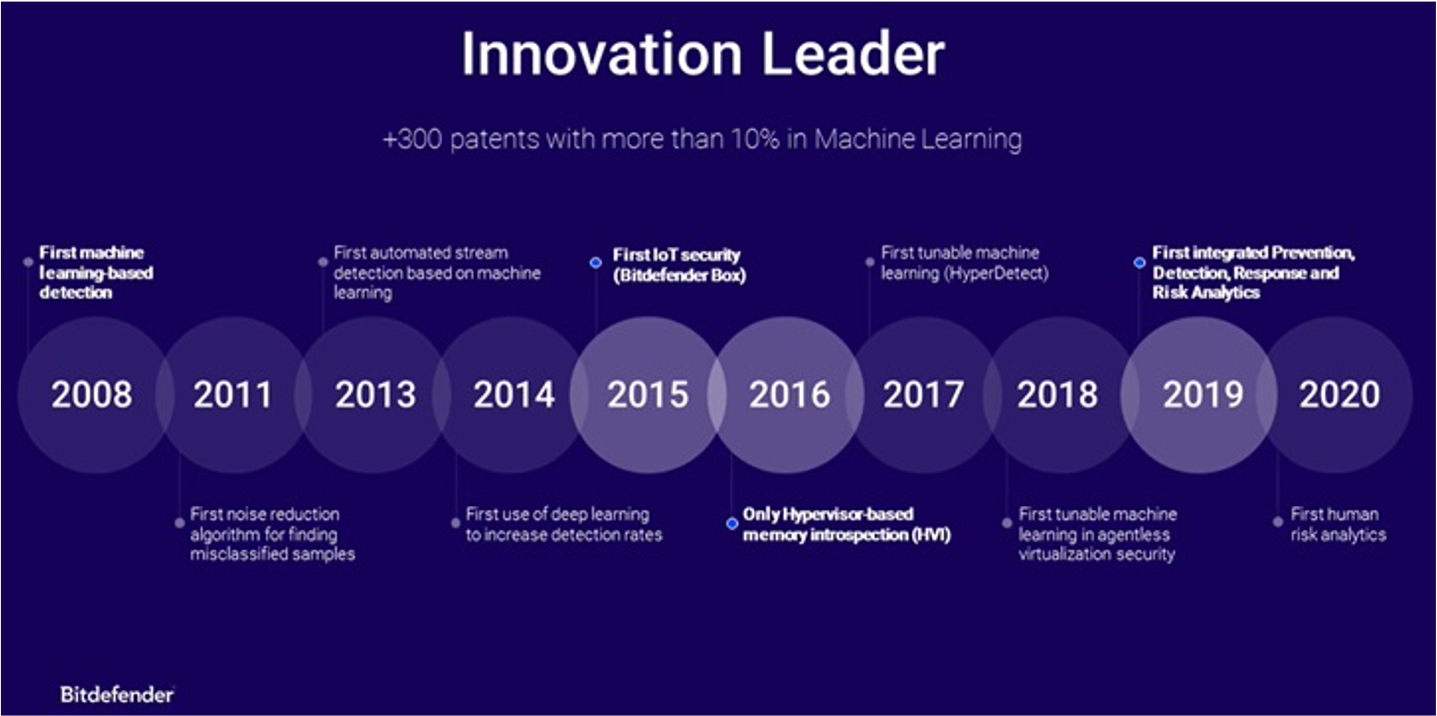

Bitdefender terus mengembangkan dan melatih algoritme machine learning untuk tujuan keamanan siber sejak 2008.

Dengan lebih dari 30 paten yang dikeluarkan untuk teknologi Machine Learning Bitdefender, khususnya pengetahuan tentang perilaku malware.

Dan bagaimana algoritme machine learning melengkapi peneliti keamanan yang membuat dunia berbeda dalam menawarkan perlindungan terbaik terhadap malware.

Recent Comments